Imagens e vídeos falsos sobre a suposta captura do presidente da Venezuela, Nicolás Maduro, se espalharam rapidamente pelas redes sociais após a operação militar dos Estados Unidos no país. Em poucas horas, conteúdos gerados por inteligência artificial (IA) ou retirados de contexto acumularam milhões de visualizações, confundindo usuários e embaralhando fatos com ficção.

A avalanche de desinformação foi impulsionada pela combinação entre a escassez de informações oficiais em tempo real e o acesso cada vez mais fácil a ferramentas de IA altamente realistas. No vácuo informativo, imagens falsas passaram a ocupar espaço, criando versões “críveis” dos acontecimentos — difíceis de distinguir, mesmo para quem tenta checar antes de compartilhar.

A captura de Maduro, segundo o anúncio oficial, ocorreu em 3 de janeiro de 2026. Forças especiais dos Estados Unidos teriam prendido o presidente em Caracas e o levado ao país norte-americano, onde ele responderia a acusações relacionadas a narcotráfico e narco-terrorismo. O pronunciamento do presidente dos EUA, Donald Trump, serviu de gatilho para a explosão de conteúdos enganosos nas plataformas digitais.

Minutos após a declaração, começaram a circular fotos falsas geradas por IA e vídeos antigos reapresentados como registros da operação. Entre eles, imagens de Maduro escoltado por supostos agentes da DEA, cenas de mísseis atingindo Caracas e vídeos de multidões comemorando nas ruas — tudo falso ou fora de contexto.

O alcance foi ampliado não apenas por perfis anônimos, mas também por influenciadores e políticos locais, que repostaram os materiais com legendas que reforçavam narrativas de vitória e humilhação do líder venezuelano. Em alguns casos, as postagens permaneceram no ar mesmo após questionamentos públicos.

De acordo com a NewsGuard, sete publicações enganosas — cinco imagens e dois vídeos — ultrapassaram 14 milhões de visualizações no X (antigo Twitter) em menos de dois dias. Conteúdos semelhantes também circularam em plataformas da Meta e no TikTok, com menor engajamento, mas impacto suficiente para moldar a percepção inicial do público.

Um dos motivos para a eficácia desse tipo de desinformação é que as imagens não são absurdas: elas se aproximam do que as pessoas esperam ver. Em vez de cenas claramente irreais, apresentam versões plausíveis da operação, capazes de driblar filtros rápidos de desconfiança.

Entre os casos destacados pela NewsGuard está uma imagem de Maduro vestindo um suposto “pijama” branco dentro de uma aeronave militar. Apesar da aparência convincente, a foto exibia falhas típicas de IA, como janelas duplicadas na fuselagem. Outro exemplo foi um “selfie” de um soldado ao lado de um prisioneiro encapuzado, apresentado como registro da captura, mas que na verdade é de 2003 e mostra a prisão de Saddam Hussein. Já um vídeo de helicóptero pousando em um complexo militar havia sido gravado meses antes, em Fort Bragg, nos Estados Unidos.

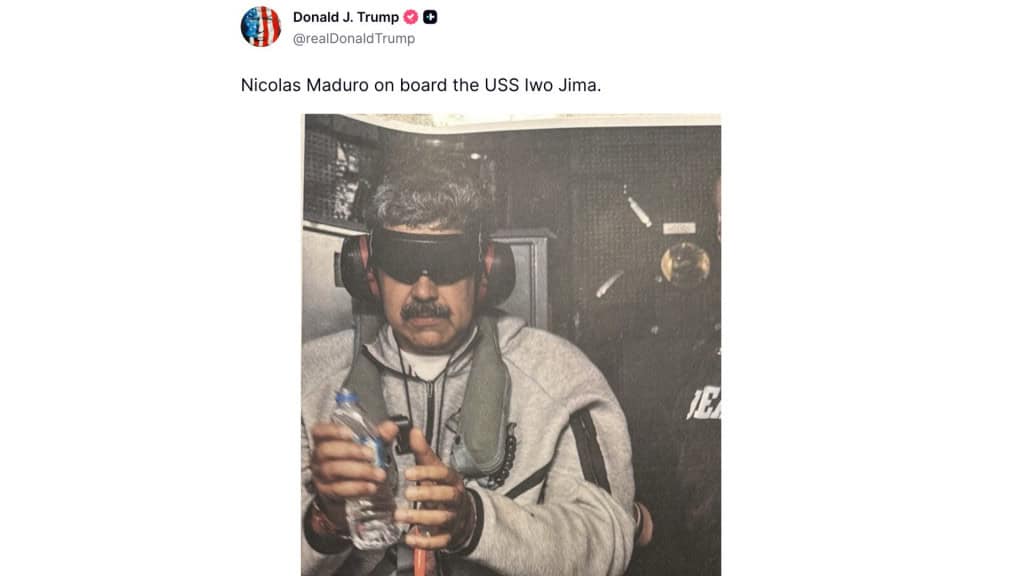

Sobre a operação real, a versão oficial indica que Maduro foi levado de helicóptero até o navio USS Iwo Jima, vestindo roupas esportivas cinzas, óculos escuros e fones de ouvido — imagem divulgada pelo próprio Donald Trump.

Ferramentas como busca reversa de imagens, detectores de conteúdo gerado por IA e sistemas de checagem colaborativa ajudam a identificar esse tipo de material, mas têm limitações. Quando a imagem “parece real”, o processo de verificação se torna mais lento e complexo. Procuradas pelo The Guardian, Meta, X e TikTok não informaram como atuaram para conter a circulação massiva desses conteúdos enganosos.

*Da Redação do BOA NOTÍCIA PB com informações e imagem do Portal OLHAR DIGITAL

***BOA NOTÍCIA PB, a informação que faz bem